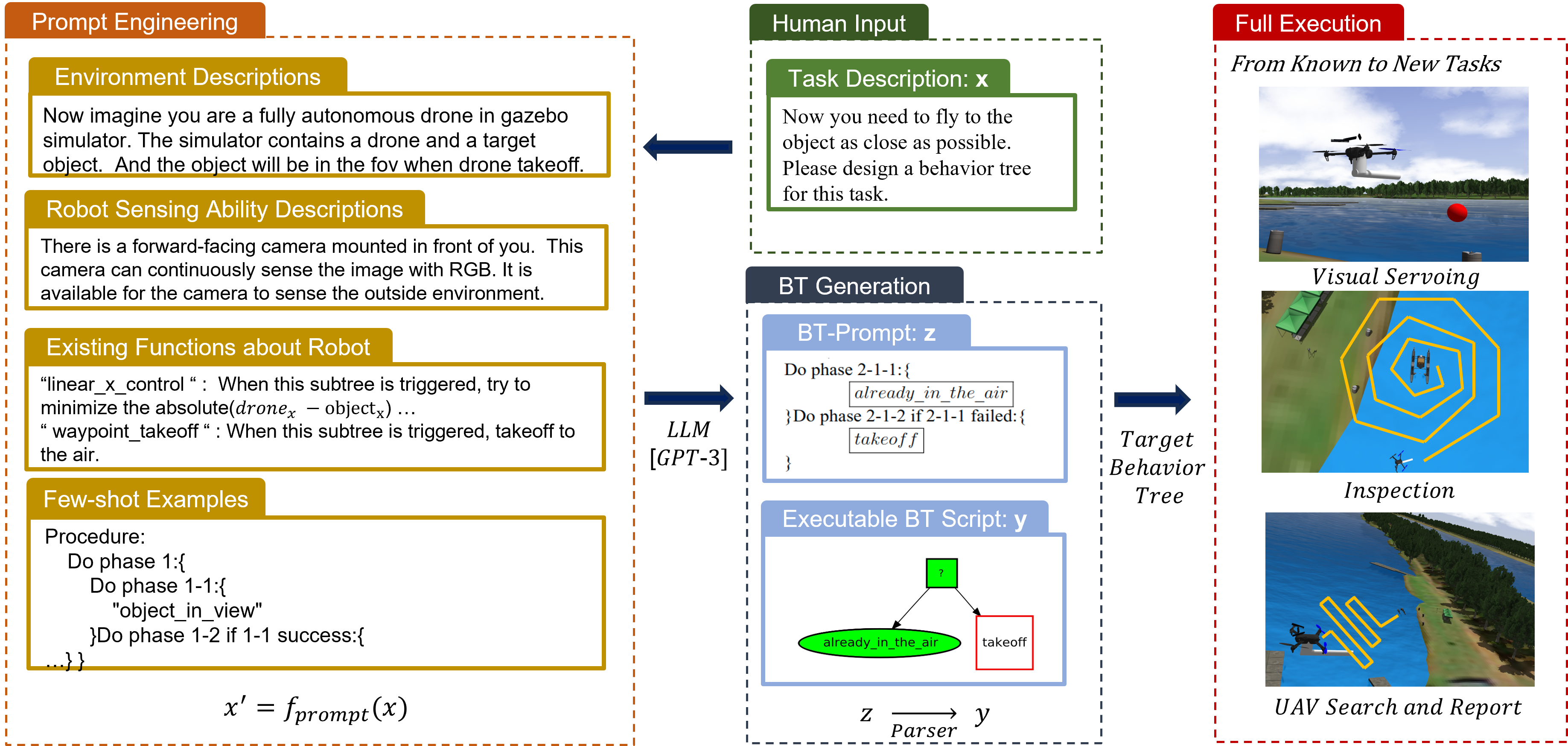

An High-level Task Planner using LLM-Generated Behavior Tree for Aerial Navigation and Manipulation

Project Link

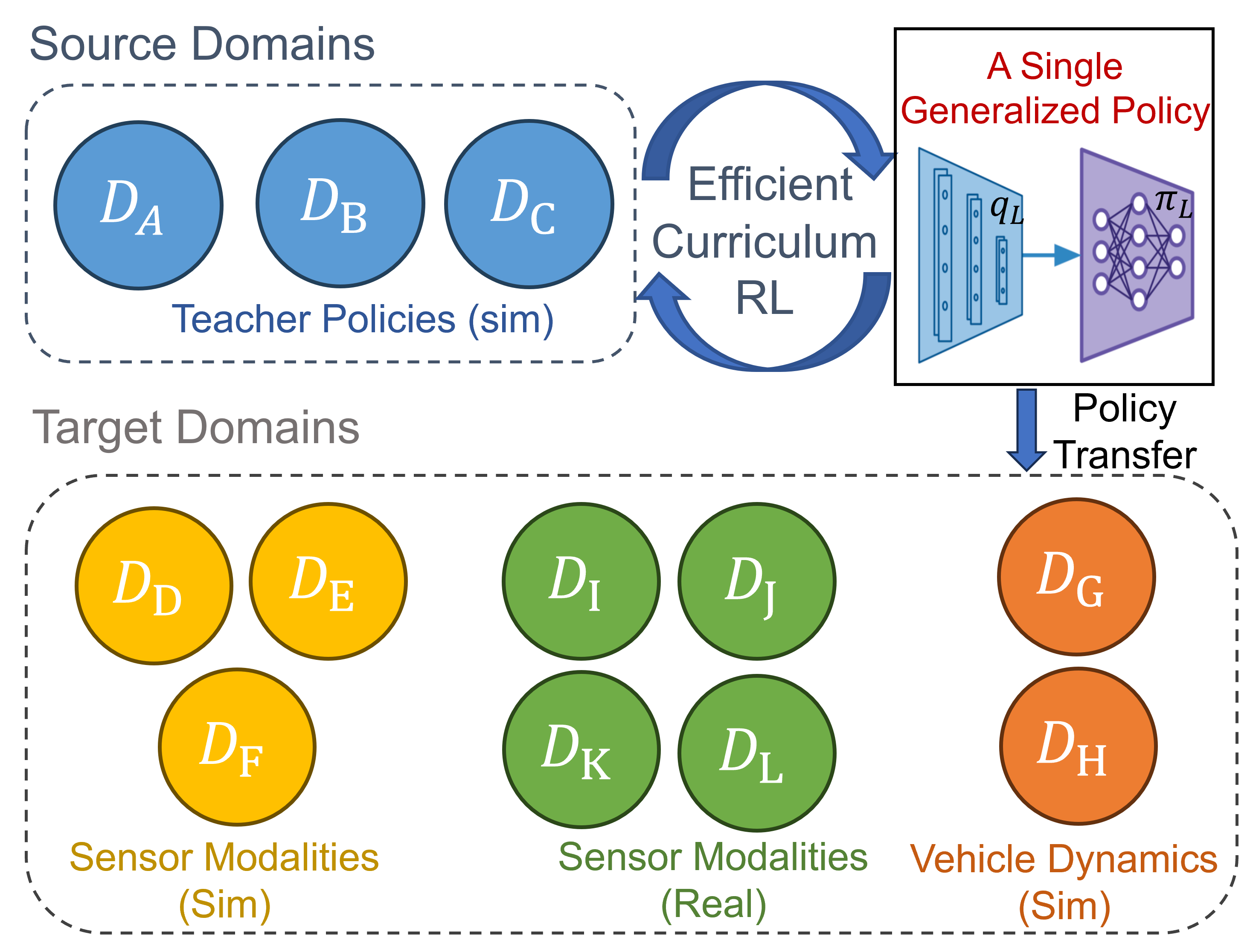

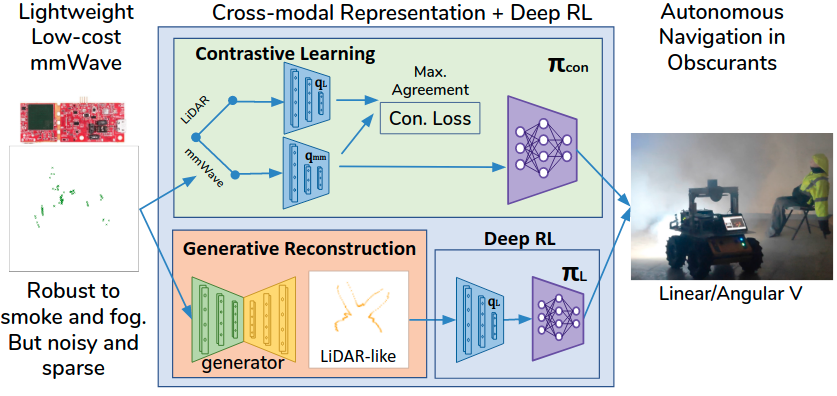

Efficient Transfer Reinforcement Learning of Single Policy for Robust Perception and Resource-constraint Robot Navigation

Project Link

An Evaluation Framework of Human-Robot Teaming for Navigation among Movable Obstacles via Virtual Reality-based Interactions

Project Link

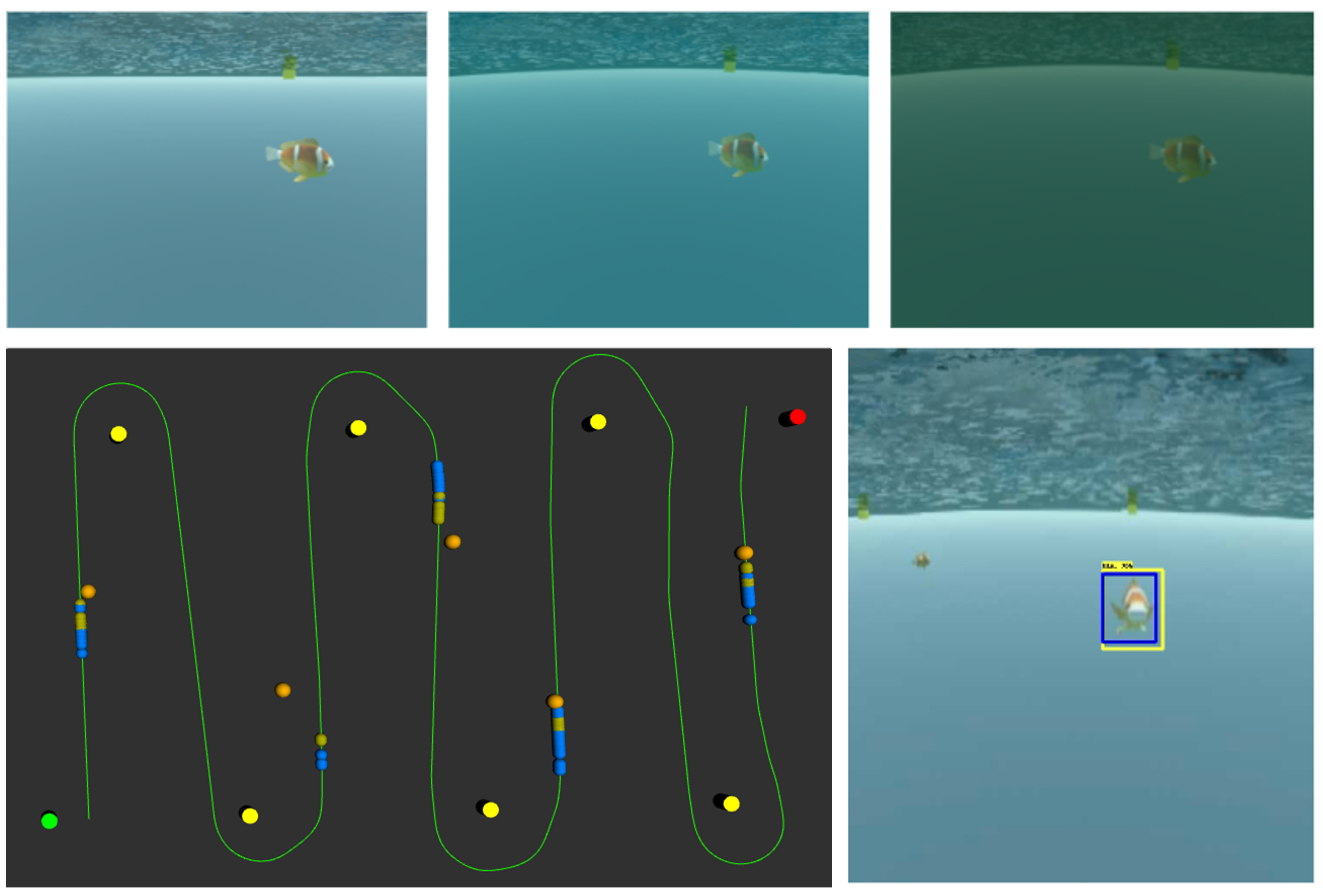

Towards More Efficient EfficientDets and Real-Time Marine Debris Detection

Project Link

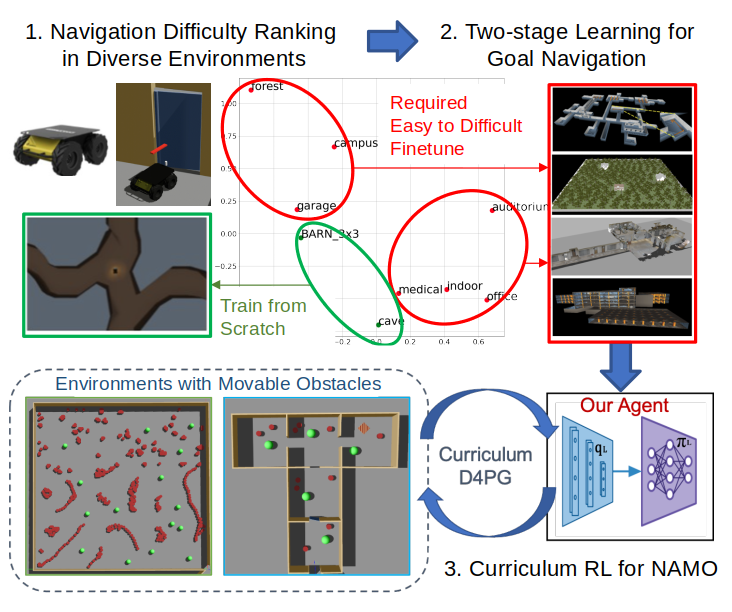

Curriculum Reinforcement Learning from Avoiding Collisions to Navigating among Movable Obstacles in Diverse Environments

Project Link

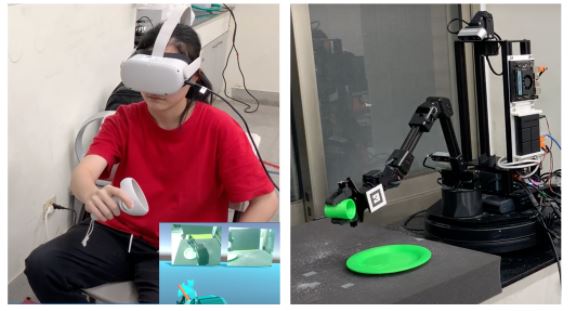

WFH-VR: Teleoperating a Robot Arm to set a Dining Table across the Globe via Virtual Reality

Project Link

Fed-HANet: Federated Visual Grasping Learning for Human Robot Handovers

Project Link

應用於輔助視障人士導航之導盲機器人和語意回饋系統與超寬頻信標

<我們開發出一盲人導航系統、包含一導航機器人、回饋用手把、超寬頻信標及語意回饋系統。此導航系統利用深度強化學習進行導航並利用同步地位與建模或超寬頻進行定位。我們也進行使用者體驗來評估此系統之優劣。

Project LinkDARPA 地底機器人競賽

我們於2019年起以Team NCTU之身份參加DARPA地底機器人競賽(DARPA Subterranean Challenge)。我們開發出一整套無人地上載具系統以及無人飛船系統以在地底進行探勘,行駛在崎嶇的路面以進行搜尋搜救任務。

Project Link Field Robotiscs paper linkDuckiepond

Duckiepond 是一個包含軟體系統、教材以及水面自駕船Duckieboat的教育與研究環境。Duckieboat易於複製、其零件都可以由3D列印以及材料行取得,其軟體也是開源的套件包。

Project LinkBrandname-based Manipulation

我們開發一個方法,其可在雜亂的物品堆中辨別片斷的商標資訊,並將其依照指定姿勢放置於置物架或是輸送帶上。我們主要貢獻為:1)提供訓練以及驗證的開放資料集,內容包含不同視角的、片斷的商標。2)對於我們的FCN Model進行驗證,該網路能對物體姿態進行預測並用以完成抓取的任務。3)呈現兩個協作機械手臂夾爪在商標被遮蔽時仍然能完成任務。 Project Link

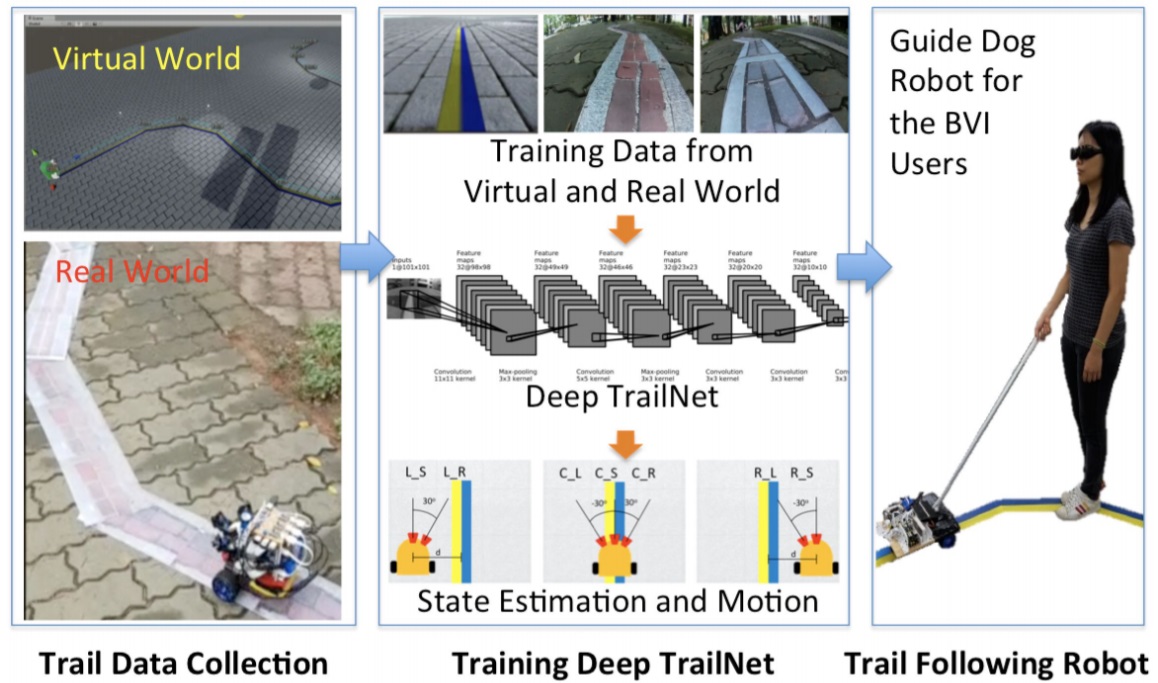

機器導盲犬計畫

我們開發一個機器人導盲犬,使用基於視覺的學習方法,在各種普通步行環境的地形上自主追踪人造小徑,以便為盲人或視覺障礙人士(BVI)提供獨立導航。

Project Link

鴨子城計畫: 一個開源,不昂貴且靈活的機器人自學研究平台

在鴨子城,居民(鴨子)通過自主移動服務(鴨子車)在城市裡移動。 鴨子城設計成本低,模組化設計,但仍然可以實現全面自駕車平台的研究和教育機會。

Project Link

Duckietown Summer School in 2017

提供盲人或是弱視者之穿戴式導航系統

為了使視障人士能便利的使用此輔具,我們團隊開發具有可穿戴式、輕巧、節能的系統。 並且在安全考量上,本系統致力於提供對場景的感知,以獨立判斷上下坡道、障礙物以及地標。 視障人士能透過非視覺之互動裝置,如以振動器或點字,即時得知周圍的環境訊息。 Poster Website (2014)

RobotX 競賽

參與首屆RobotX競賽,偵測與追蹤特殊符號以幫助自走機器艇的停靠任務。RobotX於2014年10月在新加坡舉辦。

此競賽的目的在於挑戰各組開發獨特的追蹤技術以及機器人於海洋發展等重要議題。

我們主要的設計目標在於:

1. 克服因移動、從不同距離與角度偵測、風造成的彎曲、影像斷層等形變、光線角度不同造成的色彩差所造成偵測困難 。

2. 需要及時、快速、準確且即時的判斷決策

MIT/Olin team 贏得了競賽組的第一名。

Paper

MIT News

利用空間位置排序之場景文字偵測與辨識

我們 使用同步定位技術(SLAM)以 「磁磚」的概念提取空間中的平面, 所偵測的可作為偵測場景文字的先決條件, 並能合併在不同時間點所偵測的文字,以提高準確度。 Paper

真實場景文字對視覺注意力的影響

哪個地方可最容易發現文字?

本研究的目的是調查場景文字影響注意力的因素,我們發現主要的因素有:

1. 在控制實驗中,我們證實文字比同體積的其他物件更能引起注意 。

2. 典型可預期的擺放位置

3. 文字具有特別的視覺特徵, 能提高對人類的吸引力。例如:顏色、筆畫方向、對比度…等。

4. 文字的語意內容在本實驗沒有發生影響,推論視覺注意力主要由較低階的文字特徵所影響 。

5. 對文字的吸引程度取決於觀察者對字體的熟悉度及語言模式。

Paper

不完整文字的識別

你能閱讀這些句子嗎?

過去的研究已經發現,在英文文字識別中,每個字母不是同等重要 。 亦即,改變外部或前方的的字母會使文字較難辨識 。同樣的結果也發 現中文字,先寫的筆順對整體文字辨識的影響較大。這項研究透過像素 級別(pixel-level)奇異值分解法SVD,來比較高階筆順及低階特徵值 對受試者理解程度 。在我們的研究結果說明,透過SVD所選取的筆畫大 多為先寫下的筆畫。此外,我們的結果亦發現筆劃與中文字的輪廓也有著一定的關係。 can identify first-written strokes. Furthermore, our results suggest that contour may be correlated with stroke writing order. Paper Slides